如何使用BigDL训练AI模型 BigDL分布式深度学习框架入门

时间:2025-08-02 15:15:07

bigdl是一个基于Apache Spark的分布式深度学习框架,非常适合熟悉Spark或需在大数据环境下进行深度学习的人群。其最大优势在于可以直接运行于Spark集群之上,无需额外部署深度学习框架。以下是安装和使用bigdl的步骤: 首先,需要配置JavaScala和Spark(推荐版本为。请设置spark_home和java_home环境变量。 通过pip命令安装bigdl:`pip install bigdl`新手用户可以从高层API开始学习bigdl。使用nncontext创建上下文,并定义模型结构。注意,你需要将数据加载为Spark DataFrame或RDD格式。在进行分布式训练时,请使用spark-submit启动脚本。配置master地址、executor内存和核心数以确保高效的集群处理能力。调试过程中,建议从小规模数据开始测试,并结合日志排查问题。同时,在Jupyter Notebook中启用实时日志输出也是一个好方法。掌握了这些基本步骤后,新手用户将能够高效地使用bigdl进行深度学习任务。

训练AI模型听起来很“高大上”,但用对了工具其实也不难。BigDL是一款基于Apache Spark的分布式深度学习框架,特别适合熟悉Spark或需要在大数据环境下进行深度学习的用户。它可以直接运行在Spark集群上,避免了额外部署深度学习框架的麻烦。

如果你想从零开始接触BigDL,这篇指南会解答你的疑问并提供有效建议,助你顺利入门。

安装与环境准备:别跳过这一步

BigDL 需要 Java、Scala 和 Spark 环境,因此初期可能有些难度。确保在你的系统中已正确安装 JDK(Java Development Kit)并选择 Java 以避免版本兼容性的问题。

首先安装Spark,BigDL推荐使用特定版本如Spark 确保先确认其版本后再下载。接着设置SPARK_HOME和JAVA_HOME,为避免代码运行时出现错误,必须正确配置这两个环境变量。

安装BigDL有两种方法:一是使用pip进行Python版本的安装(适合新手),二是通过下载预编译包或手动构建源码(适用于有经验的大牛)。

如果你只是想快速试一下,pip 安装是最直接的方式:

pip install bigdl登录后复制

写第一个训练程序:不要太复杂

初次接触 BigDL 编程时,避免盲目照搬 TensorFlow 或 PyTorch 思维,可以尝试使用基于 Spark DataFrame 的高级 API(近似于 Keras),或是直接采用更底层的 Spark RDD 模式。这样能更灵活地利用 Spark 数据处理能力。

选择高级API开始,如使用nncontext创建执行上下文,并定义模型结构。这是入门步骤的简单指南。

from bigdl.nncontext import * from bigdl.dllib.keras.models import Sequential from bigdl.dllib.keras.layers import * sc = init_nncontext() model = Sequential() model.add(Dense(12, input_dim=8, activation='relu')) model.add(Dense(8, activation='relu')) model.add(Dense(1, activation='sigmoid')) model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy']) model.fit(x_train, y_train, epochs=150, batch_size=10)登录后复制

这段代码确实很熟悉!因为它完全模仿了Keras的风格。BigDL的设计初衷是尽可能地贴近主流深度学习框架,从而降低学习门槛。

在分布式训练时,务必使用Spark的格式(如DataFrame或RDD)读取数据,切勿使用NumPy数组。这是初学者容易忽视的地方,易致程序无法运行。

分布式训练设置:别让资源浪费了

BigDL的最大优点在于能够利用Spark集群进行分布式训练,但如果未正确配置,可能会导致仅使用本地资源而不充分挖掘集群的潜力。

启动时要用 spark-submit 来运行脚本,并且指定相关的参数,比如:

spark-submit \ --master spark://your-spark-master:7077 \ --executor-memory 4g \ --total-executor-cores 8 \ your_script.py登录后复制

了解Spark集群配置的要点如下: `master`字段应指向你的Spark集群的地址。 设置`executor-memory`和`total-executor-cores`以确定可用的计算资源。 在云平台上(如阿里云、AWS)运行时,需遵循平台文档中的参数调整指南。

此外,BigDL兼容多后端如CPU、OpenMP和MKL加速优化。若你的设备启用了MKL,请确保启动以实现显著速度提升。

常见问题与调试技巧:别急着问论坛

在使用BigDL进行程序开发时,常见的错误包括: 类缺失或方法找不到(通常由不匹配的库版本引起) JVM启动失败(可能由于内存不足或Java配置不当) 数据格式不符(需确保Spark与深度学习数据格式兼容)

当问题出现时,不要立刻转向 Stack Overflow,先检查一下日志和堆栈信息。BigDL 有时的错误解释不够清晰,但这通常可以通过结合 Spark 日志找到根本原因。

调试建议: 小规模数据先行测试,确保逻辑无误后扩大规模。 使用 `model.summary` 查看模型结构是否准确。 日志级别设置为 INFO 或 DEBUG,收集更多信息以诊断问题。 遇到不明原因的错误时,尝试单机模式运行(local)进行排查。

在Jupyter Notebook中开发时,请务必启用init_nncontext(log_output=True)以查看实时日志,便于问题排查。

BigDL入门其实并不困难,但也存在一些陷阱。特别是环境配置与数据格式转换方面需要仔细处理。通过逐步学习,你也可以轻松掌握它。

以上就是如何使用BigDL训练AI模型 BigDL分布式深度学习框架入门的详细内容,更多请关注其它相关文章!

热门推荐

-

华为手机上传到中转站怎么关闭 华为手机如何关闭上传到中转站华为手机如何关闭上传到中转站:对于华为手机不少用户都在使用啦,当然这可手机功能也是非常强大的。对于这款世界如何关闭上传到中转站呢?小编为玩家整理了相关内容,下面一起来看看相关的信息。

华为手机上传到中转站怎么关闭 华为手机如何关闭上传到中转站华为手机如何关闭上传到中转站:对于华为手机不少用户都在使用啦,当然这可手机功能也是非常强大的。对于这款世界如何关闭上传到中转站呢?小编为玩家整理了相关内容,下面一起来看看相关的信息。 -

三国志11威力加强版庙和遗迹如何触发 三国志11庙和遗迹坐标位置机制详解三国志11威力加强版庙和遗迹如何触发:在三国志11游戏中很多玩法还是挺多的,对于游戏中庙和遗迹我们又该如何触发呢?想必不少玩家还是不了解的,小编整理了三国志11庙和遗迹机制详解,下面一起来看看相关的信息。

三国志11威力加强版庙和遗迹如何触发 三国志11庙和遗迹坐标位置机制详解三国志11威力加强版庙和遗迹如何触发:在三国志11游戏中很多玩法还是挺多的,对于游戏中庙和遗迹我们又该如何触发呢?想必不少玩家还是不了解的,小编整理了三国志11庙和遗迹机制详解,下面一起来看看相关的信息。 -

学习通如何查看学号工号_学习通查看学号工号方法介绍学习通查看学号工号方法介绍:对于学习通这款软件功能还是挺多的,在这款软件想要查询工号又该如何搞呢?这也是很多用户不了解的,在这里为用户整理了学习通查看工号学号方法介绍,下面一起来看看相关的信息。

学习通如何查看学号工号_学习通查看学号工号方法介绍学习通查看学号工号方法介绍:对于学习通这款软件功能还是挺多的,在这款软件想要查询工号又该如何搞呢?这也是很多用户不了解的,在这里为用户整理了学习通查看工号学号方法介绍,下面一起来看看相关的信息。 -

学习通如何添加好友_学习通添加好友方法教程学习通添加好友方法教程:在学习通这款软件功能还是挺多的,对于这款软件想和别人聊天又该如何搞呢?这也是很多玩家不了解的,小编整理了学习通添加好友方法介绍,下面一起来看看相关的信息。

学习通如何添加好友_学习通添加好友方法教程学习通添加好友方法教程:在学习通这款软件功能还是挺多的,对于这款软件想和别人聊天又该如何搞呢?这也是很多玩家不了解的,小编整理了学习通添加好友方法介绍,下面一起来看看相关的信息。 -

uc浏览器收藏如何设置密码_uc浏览器隐私收藏设置方法介绍uc浏览器收藏如何设置密码:对于uc浏览器这款软件想必很多用户都在使用,当然在这款软件隐私收藏如何加密呢?想必很多玩家还是不了解的,小编整理了相关内容介绍,下面一起来看看相关的信息。

uc浏览器收藏如何设置密码_uc浏览器隐私收藏设置方法介绍uc浏览器收藏如何设置密码:对于uc浏览器这款软件想必很多用户都在使用,当然在这款软件隐私收藏如何加密呢?想必很多玩家还是不了解的,小编整理了相关内容介绍,下面一起来看看相关的信息。 -

魔法少女天穹法妮雅怎么使用物品魔法少女苍穹法妮雅是一款冒险游戏,小伙伴将饰演一位普通女生,在回家路上碰到怪物偷袭,日暮途穷之时碰到一本奇书,并与奇书缔结契约,成为魔法少女

魔法少女天穹法妮雅怎么使用物品魔法少女苍穹法妮雅是一款冒险游戏,小伙伴将饰演一位普通女生,在回家路上碰到怪物偷袭,日暮途穷之时碰到一本奇书,并与奇书缔结契约,成为魔法少女 -

GTA5人物特殊技能有哪些 GTA5人物特殊技能怎么使用GTA5是一款自由度很高的角色饰演游戏,在故事模式中含有三个角色能够使用,每一个角色都有分歧的特别技能,那么GTA5角色的特别技能有哪些

GTA5人物特殊技能有哪些 GTA5人物特殊技能怎么使用GTA5是一款自由度很高的角色饰演游戏,在故事模式中含有三个角色能够使用,每一个角色都有分歧的特别技能,那么GTA5角色的特别技能有哪些 -

如何使用BigDL训练AI模型 BigDL分布式深度学习框架入门bigdl是一个基于ApacheSpark的分布式深度学习框架,非常适合熟悉Spark或需在大数据环境下进行深度学习的人群

如何使用BigDL训练AI模型 BigDL分布式深度学习框架入门bigdl是一个基于ApacheSpark的分布式深度学习框架,非常适合熟悉Spark或需在大数据环境下进行深度学习的人群 -

如何用 AI 瑜伽教学工具与豆包搭配完成瑜伽训练?教程解读在构建智能生态的过程中,将人工智能(AI)与瑜伽工具巧妙结合的核心在于实现个性化和实时反馈的瑜伽体验

如何用 AI 瑜伽教学工具与豆包搭配完成瑜伽训练?教程解读在构建智能生态的过程中,将人工智能(AI)与瑜伽工具巧妙结合的核心在于实现个性化和实时反馈的瑜伽体验 -

有趣的儿童益智游戏脑力训练大全 2025好玩小伙伴们快来一起享受益智游戏带来的乐趣吧!我们为大家精心挑选了一些有趣又富有教育意义的游戏,这些游戏不仅可以锻炼孩子的身体和感官,更重要的是它们能有效促进孩子大脑

-

激战2幻灵师训练攻略 激战二幻灵的技能怎么学一、激战2玩家分享只萌不蠢的PVP唤灵师攻略混伤流唤灵师的特点大家都很清楚,激战的混伤流路线专精也很明确

-

王者荣耀训练模式怎么开启随着移动电子竞技的流行,王者荣耀以其简单的操作、丰富的英雄选择和激烈的对抗吸引了一大批忠实玩家。对于新手而言,在对战前熟悉英雄技能和地图布局是提升技能的关键步骤

-

豆包 AI 大模型怎样和 AI 模型配音选择工具结合选择配音?教程解读在实现高效配音的流程中,结合豆包AI与专业AI配音工具的核心步骤如下:明确主题与目的:首先确定你希望录制的声音内容,例如是商业广告还是个人故事讲述

豆包 AI 大模型怎样和 AI 模型配音选择工具结合选择配音?教程解读在实现高效配音的流程中,结合豆包AI与专业AI配音工具的核心步骤如下:明确主题与目的:首先确定你希望录制的声音内容,例如是商业广告还是个人故事讲述 -

豆包 AI 大模型如何和 AI 模型风格设计工具结合设计风格?攻略全民k歌:歌房舞台效果开启指南腾讯出品的全民K歌,以其智能打分、修音、混音和专业音效等功能,深受K歌爱好者喜爱

豆包 AI 大模型如何和 AI 模型风格设计工具结合设计风格?攻略全民k歌:歌房舞台效果开启指南腾讯出品的全民K歌,以其智能打分、修音、混音和专业音效等功能,深受K歌爱好者喜爱 -

豆包AI能否进行工业设计评审 豆包AI三维模型分析功能实测豆包ai在工业设计评审中具备一定作用,但无法完全替代人类专家。1.它可进行初步模型检查,识别几何错误;2.支持设计规范符合性检查,自动验证是否符合设定标准;3.提

豆包AI能否进行工业设计评审 豆包AI三维模型分析功能实测豆包ai在工业设计评审中具备一定作用,但无法完全替代人类专家。1.它可进行初步模型检查,识别几何错误;2.支持设计规范符合性检查,自动验证是否符合设定标准;3.提 -

想将 AI 模型数据整理工具与豆包联用整理数据?详细步骤豆包可提高数据整理效率。一、明确需求:确定要整理的数据类型,如文本、表格或半结构化数据,豆包更适合处理文本信息,表格数据建议先转文本格式

想将 AI 模型数据整理工具与豆包联用整理数据?详细步骤豆包可提高数据整理效率。一、明确需求:确定要整理的数据类型,如文本、表格或半结构化数据,豆包更适合处理文本信息,表格数据建议先转文本格式 -

豆包AI安装后如何配置多GPU并行 豆包AI分布式计算环境搭建本篇文章详细阐述了豆包AI在配置后能如何利用多GPU进行高效的并行计算,提高系统的性能和效率。我们将指导您完成从安装到成功搭建过程中的关键步骤,确保您能够最大程度

豆包AI安装后如何配置多GPU并行 豆包AI分布式计算环境搭建本篇文章详细阐述了豆包AI在配置后能如何利用多GPU进行高效的并行计算,提高系统的性能和效率。我们将指导您完成从安装到成功搭建过程中的关键步骤,确保您能够最大程度 -

群雄时代陷阵营深度解析 地形战场破阵战术全公开特战精英们注意了!今天为大家揭秘特种部队的超级战队陷阵营全方位评估!这支部队不但能召唤鬼魂般的力量,还能创造自己专属的安全空间

群雄时代陷阵营深度解析 地形战场破阵战术全公开特战精英们注意了!今天为大家揭秘特种部队的超级战队陷阵营全方位评估!这支部队不但能召唤鬼魂般的力量,还能创造自己专属的安全空间 -

华为手机定位精度如何提升?多源数据融合技术深度解析华为手机定位精度的关键在于多源数据融合技术。其常见的定位技术包括:1.gps;2.glonass;3.galileo;4.北斗;5.a-gps;6.wi-fi定位

华为手机定位精度如何提升?多源数据融合技术深度解析华为手机定位精度的关键在于多源数据融合技术。其常见的定位技术包括:1.gps;2.glonass;3.galileo;4.北斗;5.a-gps;6.wi-fi定位 -

三角洲行动s5深度定制2任务攻略三角洲行动S度定制已开启!想要挑战高难度模式?你必须掌握以下技巧:确定指定枪械:首先,你需要携带特定武器,这将有助于快速定位目标

三角洲行动s5深度定制2任务攻略三角洲行动S度定制已开启!想要挑战高难度模式?你必须掌握以下技巧:确定指定枪械:首先,你需要携带特定武器,这将有助于快速定位目标 -

背单词最好用的app是哪个 学习模式多样的背单词软件介绍那么,在学习语言的过程中,丰富词汇量是大家掌握英语的基本条件。因此,市面上用来背单词的最佳应用是什么呢?市面上的背单词应用程序种类繁多,它们可以满足不同用户的需求

背单词最好用的app是哪个 学习模式多样的背单词软件介绍那么,在学习语言的过程中,丰富词汇量是大家掌握英语的基本条件。因此,市面上用来背单词的最佳应用是什么呢?市面上的背单词应用程序种类繁多,它们可以满足不同用户的需求 -

《不,我要学习》 手残和大佬的体验两极分化在当下激烈竞争的游戏市场中,独立游戏以其独特的设定与挑战性玩法吸引着大量玩家的关注。然而,随着游戏热度攀升,出现了对“手残党”和“技术大佬”体验极端分化的问题

《不,我要学习》 手残和大佬的体验两极分化在当下激烈竞争的游戏市场中,独立游戏以其独特的设定与挑战性玩法吸引着大量玩家的关注。然而,随着游戏热度攀升,出现了对“手残党”和“技术大佬”体验极端分化的问题 -

免费的小语种学习软件推荐 免费语言学习软件下载免费的小语种学习软件推荐。随着经济的发展,越来越多人富裕起来,开始想到外面的世界看看,出国留学或者出国旅游热潮一直不断,虽然英语被称为世界语言,但是很多地方还是多

免费的小语种学习软件推荐 免费语言学习软件下载免费的小语种学习软件推荐。随着经济的发展,越来越多人富裕起来,开始想到外面的世界看看,出国留学或者出国旅游热潮一直不断,虽然英语被称为世界语言,但是很多地方还是多 -

比亚迪腾势 N9 汽车 UWB 功能华为品牌机型仅支持 Mate XT,限定“安卓 + 鸿蒙”双框架系统今天,比亚迪旗下的豪华品牌腾势发布了“腾势问答第一期”。在这一期中,官方回应了关于腾势N操作系统更新(OTA)的相关问题,解释了升级的时长、升级推送策略以及华为手

比亚迪腾势 N9 汽车 UWB 功能华为品牌机型仅支持 Mate XT,限定“安卓 + 鸿蒙”双框架系统今天,比亚迪旗下的豪华品牌腾势发布了“腾势问答第一期”。在这一期中,官方回应了关于腾势N操作系统更新(OTA)的相关问题,解释了升级的时长、升级推送策略以及华为手 -

《中国人工智能安全承诺框架》发布xiayx7月3日消息,225世界人工智能大会暨人工智能全球治理高级别会议“人工智能发展与安全”全体会议7月26日下午在上海召开

《中国人工智能安全承诺框架》发布xiayx7月3日消息,225世界人工智能大会暨人工智能全球治理高级别会议“人工智能发展与安全”全体会议7月26日下午在上海召开 -

纯血鸿蒙双框架系统详解在华为Mate列手机中,鸿蒙双框架系统无疑是一个备受瞩目的亮点。它不仅展示了华为在操作系统领域的深厚积累和领先能力,同时也体现了其对于国内外市场需求的全面考量

纯血鸿蒙双框架系统详解在华为Mate列手机中,鸿蒙双框架系统无疑是一个备受瞩目的亮点。它不仅展示了华为在操作系统领域的深厚积累和领先能力,同时也体现了其对于国内外市场需求的全面考量 -

太极app怎么使用 太极虚拟框架app使用方法教程太极虚拟框架app使用方法教程:对于这款软件想必不少用户还是了解的,同样玩家对于这款软件又该如何使用呢?这也是很多玩家比较关注的,小编整理了太极app使用详解,下面一起来看看相关的信息。

太极app怎么使用 太极虚拟框架app使用方法教程太极虚拟框架app使用方法教程:对于这款软件想必不少用户还是了解的,同样玩家对于这款软件又该如何使用呢?这也是很多玩家比较关注的,小编整理了太极app使用详解,下面一起来看看相关的信息。 -

队长小翼王牌对决攻略大全 2025新手入门不走弯路队长小翼王牌对决如何玩,这是同名动画作品正版授权的足球竞技游戏,内中有种种的必杀技和多种模式的攻略,你能够得心应手的去体味热血对决,接下来就来讲解下队长小翼王牌对

队长小翼王牌对决攻略大全 2025新手入门不走弯路队长小翼王牌对决如何玩,这是同名动画作品正版授权的足球竞技游戏,内中有种种的必杀技和多种模式的攻略,你能够得心应手的去体味热血对决,接下来就来讲解下队长小翼王牌对 -

《第一狂战士 卡赞》添加新难度“入门”和“硬核”近期,第一狂战士:卡赞发布了Steam最新公告,强调了多项关键更新内容。此次更新不仅提升了游戏的流畅度,还加入了连击教学和难度调整机制

-

龙王大人新手攻略从入门到精通欢迎踏入龙王的奇幻世界!作为新手,不必慌张,此攻略将带你迅速入门,熟悉系统、策略和资源管理,轻松避开迷宫

-

古剑奇谭完美世界玩法介绍 新手入门指南是什么开篇即明:古剑奇谭完美世界作为一款结合了中国古典文化与现代游戏设计理念的角色扮演游戏,吸引了无数玩家的目光

-

《指间山海》新手入门须知在游戏中,玩家可以扮演英雄,在山海世界留下自己的传奇故事。主角具备独树一帜的能力,在战斗中起关键作用

最新更新

-

如何使用豆包电脑版AI云盘?详细使用指南

如何使用豆包电脑版AI云盘?详细使用指南

-

豆包AI可以离线使用吗 豆包离线功能支持情况说明

豆包AI可以离线使用吗 豆包离线功能支持情况说明

-

Perplexity AI如何验证事实准确性 Perplexity AI信息交叉验证

Perplexity AI如何验证事实准确性 Perplexity AI信息交叉验证

-

华为P70手机值得购买吗

华为P70手机值得购买吗

-

外国好玩的射击游戏下载哪些 2025耐玩的射击手游排名

外国好玩的射击游戏下载哪些 2025耐玩的射击手游排名

-

帝国权杖与文明大不列颠文明怎么样 帝国权杖与文明大不列颠文明介绍

帝国权杖与文明大不列颠文明怎么样 帝国权杖与文明大不列颠文明介绍

-

滑板游戏有哪些介绍2025 可玩性高的滑板游戏合集

滑板游戏有哪些介绍2025 可玩性高的滑板游戏合集

-

卡普空王牌 IP:《生化危机》系列全球销量突破 1.74 亿套

卡普空王牌 IP:《生化危机》系列全球销量突破 1.74 亿套

-

如何使用BigDL训练AI模型 BigDL分布式深度学习框架入门

如何使用BigDL训练AI模型 BigDL分布式深度学习框架入门

-

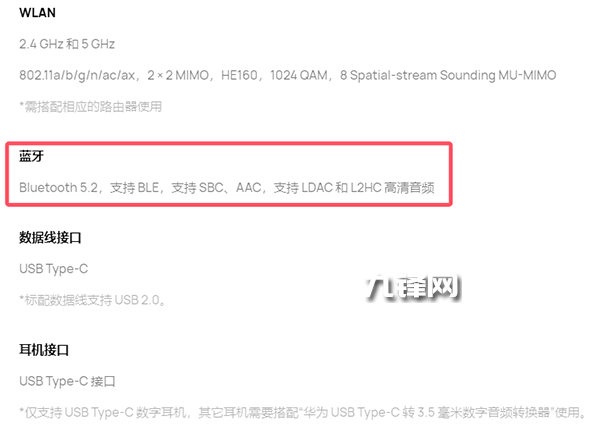

华为nova Flip的蓝牙规格和版本是多少

华为nova Flip的蓝牙规格和版本是多少

-

《英雄联盟》莲华温泉系列皮肤PV 泡温泉疗愈一夏

《英雄联盟》莲华温泉系列皮肤PV 泡温泉疗愈一夏